在机器学习的世界里,我们常常会遇到各种复杂的数据,它们可能包含大量的特征,但其中真正有用的信息却很少。

这就像是在一个杂乱无章的房间里,我们只需要找到那些真正重要的物品,而忽略掉那些无关紧要的杂物。

稀疏表示和字典学习就像是整理房间的工具,帮助我们找到那些关键的信息,让数据变得更加简洁和有用。

1. 稀疏表示:让数据“瘦身”

稀疏表示(Sparse Representation)的核心思想是用尽可能少的元素表达尽可能多的信息。

想象一下,你有一张照片,照片上有各种各样的颜色和细节。

稀疏表示就像是用一种特殊的画笔,只用几种关键的颜色和笔触,就能重新画出这张照片。

在数学上,稀疏表示就是将一个向量(数据)表示为一个字典(一组基向量)的线性组合,而且这个组合中只有少数几个系数是非零的。

稀疏表示可以大大简化学习过程,原因主要有以下几点:

- 减少计算量:因为只有少数几个非零系数,所以在处理数据时,计算量会大大减少。这就好比在一个大房间里,你只需要关注几个重要的物品,而不用去管那些无关紧要的东西,这样就节省了很多时间和精力。

- 提高模型的可解释性:稀疏表示可以让我们更清楚地看到哪些特征是重要的。在实际应用中,这有助于我们理解模型的决策过程,比如在医学诊断中,我们可以清楚地知道哪些指标对疾病的诊断起到了关键作用。

- 减少过拟合:由于稀疏表示只关注少数几个重要的特征,所以模型不会被那些无关紧要的特征所干扰,从而减少了过拟合的风险。

2. 字典学习:构建“画笔”

字典学习是稀疏表示的基础,它的目标是找到一组基向量(字典),使得数据可以被稀疏地表示。

这就好比我们有一堆颜料,字典学习就是找到那些最合适的颜料,让我们可以用最少的颜料画出最接近原画的画作。

在机器学习中,字典学习就是通过学习一组基向量,让数据能够以稀疏的方式表示出来。

字典学习的主要作用有:

- 特征提取:字典学习可以自动提取出数据中的重要特征,这些特征往往能够更好地表示数据的本质。比如在图像处理中,字典学习可以提取出图像中的关键纹理和形状特征。

- 数据压缩:通过稀疏表示,数据可以用更少的存储空间来表示,这对于大规模数据的存储和处理非常有帮助。

- 噪声去除:稀疏表示可以忽略掉那些不重要的信息,从而起到去除噪声的作用。在信号处理中,这可以帮助我们恢复出更清晰的信号。

3. 代码示例

下面通过一个简单的代码示例来演示如何使用scikit-learn库实现字典学习。

我们将使用一个简单的图像数据集,通过字典学习来提取图像的关键特征。- import numpy as np

- import matplotlib.pyplot as plt

- from sklearn.decomposition import DictionaryLearning

- # 生成一个简单的图像数据集

- np.random.seed(0)

- n_samples = 100 # 样本数量

- n_features = 100 # 每个样本的特征数量(图像大小为10x10像素)

- n_components = 10 # 字典中基向量的数量

- # 生成随机图像数据

- # data 是一个形状为(n_samples, n_features)的随机矩阵,

- # 表示100个10x10的图像。

- data = np.random.rand(n_samples, n_features)

- # 使用字典学习

- # 其中:

- # n_components:指定字典中基向量的数量

- # transform_algorithm:指定稀疏编码的算法

- # transform_alpha:正则化参数,控制稀疏编码的稀疏程度

- dict_learner = DictionaryLearning(

- n_components=n_components,

- transform_algorithm="lasso_lars",

- transform_alpha=0.1,

- )

- # 对数据进行字典学习,学习出字典中的基向量

- dict_learner.fit(data)

- # 提取字典和稀疏编码

- dictionary = dict_learner.components_

- sparse_code = dict_learner.transform(data)

- # 字典dictionary形状是(n_components, n_features),即(10, 100)

- print(dictionary.shape)

- # 稀疏编码sparse_code形状是(n_samples, n_components),即(100, 10)

- print(sparse_code.shape)

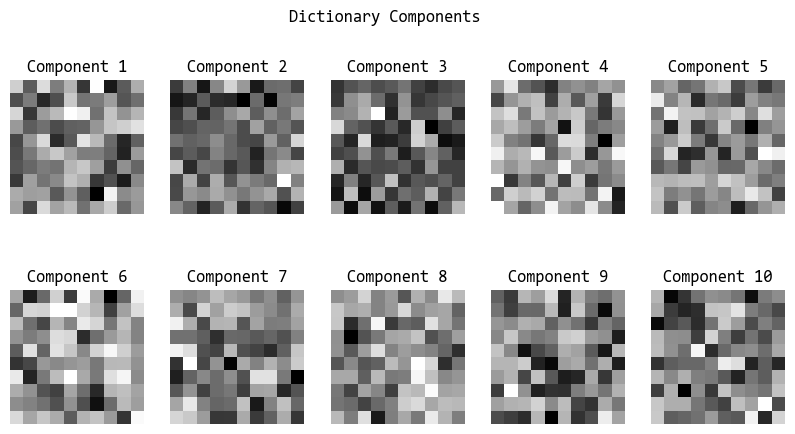

- # 可视化字典

- # 字典中的每个基向量重新塑形为10x10的图像,并以灰度图显示。

- plt.figure(figsize=(10, 5))

- for i in range(n_components):

- plt.subplot(2, 5, i + 1)

- plt.imshow(dictionary[i].reshape(10, 10), cmap="gray")

- plt.title(f"Component {i + 1}")

- plt.axis("off")

- plt.suptitle("Dictionary Components")

- plt.show()

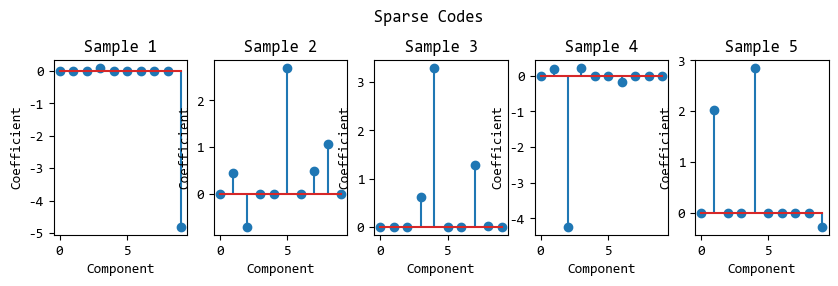

- # 可视化稀疏编码

- # 使用垂直线(茎)和标记(叶)来表示每个非零系数的位置和大小

- plt.figure(figsize=(10, 5))

- for i in range(5):

- plt.subplot(2, 5, i + 1)

- plt.stem(sparse_code[i])

- plt.title(f"Sample {i + 1}")

- plt.xlabel("Component")

- plt.ylabel("Coefficient")

- plt.suptitle("Sparse Codes")

- plt.show()

4. 总结

稀疏表示和字典学习是机器学习中非常有用的工具,它们可以帮助我们简化数据,提取关键特征,提高模型的性能。

不过,我们也要注意稀疏表示的两面性,它的优点是计算高效、抗噪、可解释;

由此带来的局限在于可能丢失弱特征、且不适合密集关联数据。

因此,实际使用时,需要通过通过交叉验证来选择合适稀疏度。

来源:程序园用户自行投稿发布,如果侵权,请联系站长删除

免责声明:如果侵犯了您的权益,请联系站长,我们会及时删除侵权内容,谢谢合作! |